超节点行业深度:驱动因素、规模选择、产业链影响及相关公司深度梳理

在人工智能技术飞速发展的当下,大模型训练与推理对算力的需求呈爆发式增长,超节点(SuperPod)应运而生并迅速崛起。作为新型算力基础设施的关键组成部分,超节点凭借卓越的性能和高效的互联架构,成为推动算力升级的核心力量,代表着算力技术的前沿方向,更是未来智能社会发展的重要支撑。超节点的概念由英伟达率先提出,其核心在于通过高效的互联协议和架构设计,实现大规模GPU集群的紧密耦合与协同工作。这种架构在模型训练和推理过程中展现出显著优势,能够有效提升算力的整体性能。如今,全球科技巨头纷纷布局,国内企业也在加速追赶,超节点行业正站在时代的风口,展现出巨大的发展潜力与变革能量,有望重塑整个算力产业的格局,为人工智能的进一步发展提供强大动力。

本报告深入剖析了超节点行业的全貌。从概念内涵、优势特性,到国内外布局案例、规模演进、产业链影响,再到相关企业的发展态势,全方位、多维度地呈现了这一前沿领域的关键信息。旨在为行业从业者、投资者以及关注技术发展的各界人士提供一份极具价值的深度参考,助力大家把握超节点行业发展的脉搏,洞察未来算力世界的走向。

1、超节点概念

超节点,英文名为SuperPod,是英伟达公司最先提出的概念。

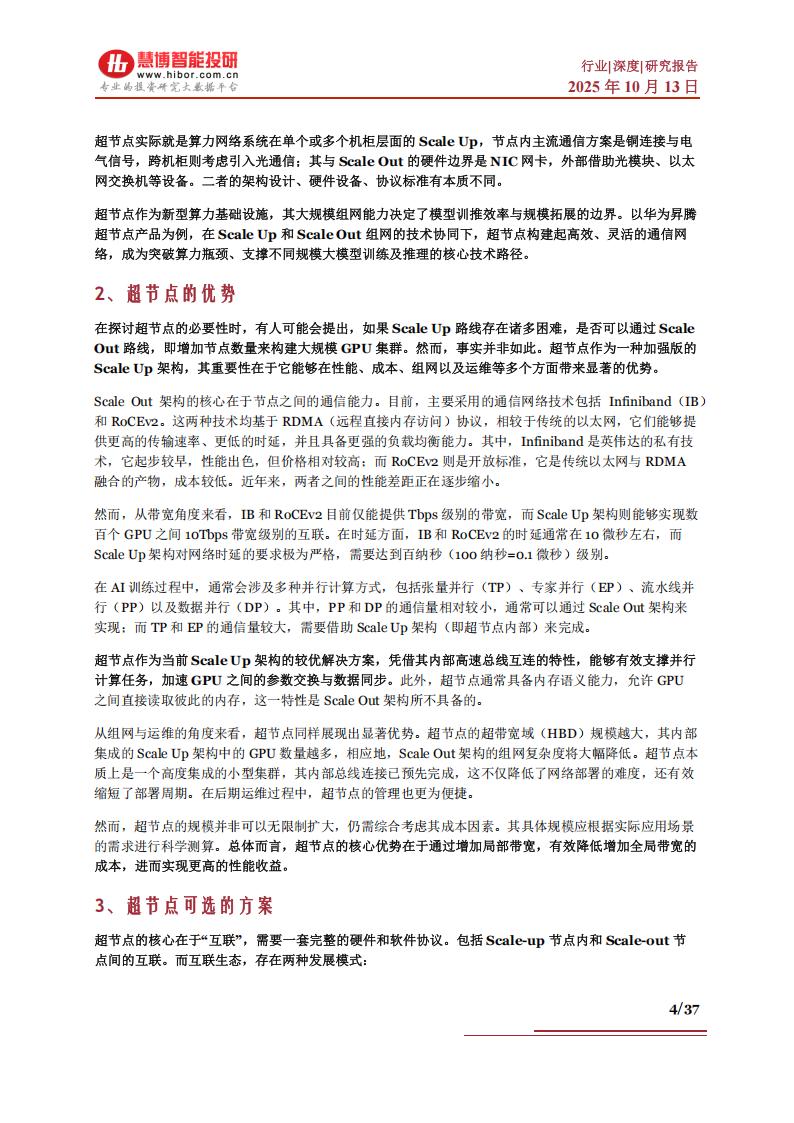

GPU作为关键的算力硬件,在AIGC大模型的训练与推理过程中发挥着至关重要的支撑作用。随着大模型参数规模的持续扩张,其对GPU集群规模的需求也在与日俱增,从千卡级别逐步迈向万卡级别,甚至未来有望达到十万卡级别乃至更高规模。在构建规模日益庞大的GPU集群时,主要可采用两种策略:Scale Up(纵向扩展)与Scale Out(横向扩展)。

以货轮为比喻,当总运力需求扩张时,Scale-up是建造更大的货轮,而Scale-out则是增加货轮的数量。Scale-up追求硬件的紧密耦合;Scale-out追求实现弹性扩展,支撑松散任务(如数据并行)。二者在协议栈、硬件、容错机制上存在本质差异,通信效率不同。

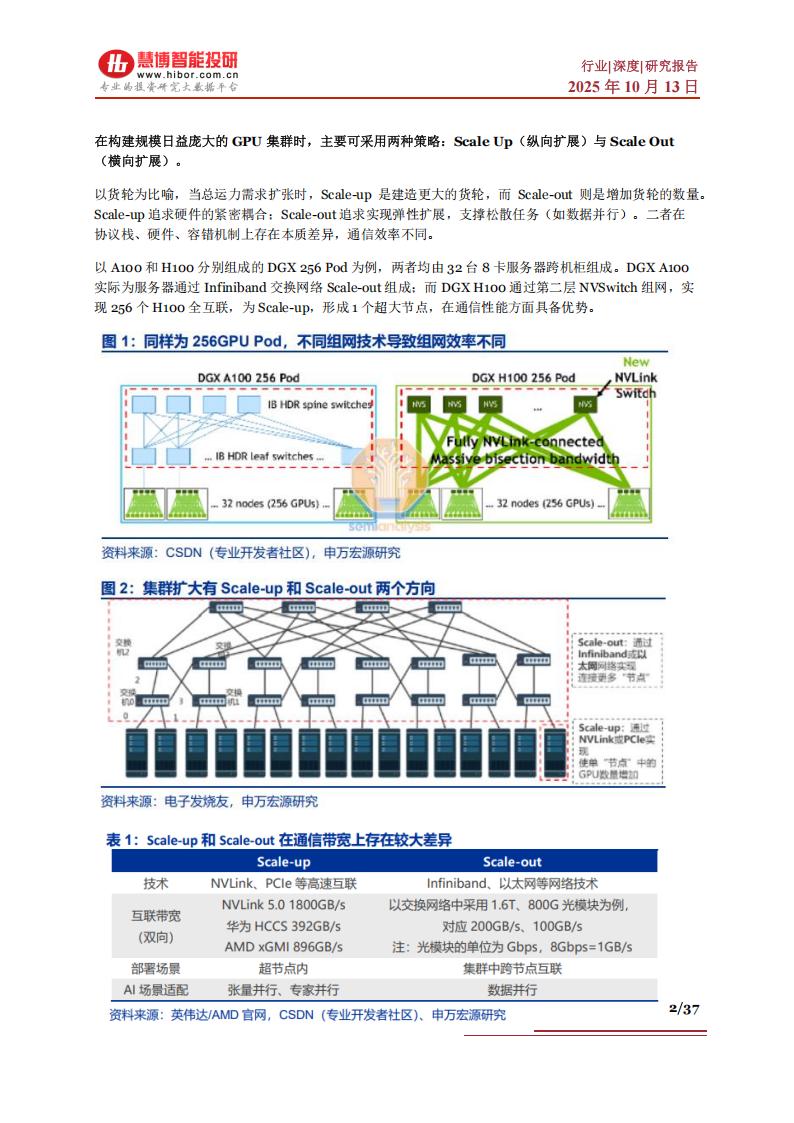

以A100和H100分别组成的DGX256 Pod为例,两者均由32台8卡服务器跨机柜组成。DGX A100实际为服务器通过Infiniband交换网络Scale-out组成;而DGXH100通过第二层NVSwitch组网,实现256个H100全互联,为Scale-up,形成1个超大节点,在通信性能方面具备优势。

Scale Up较多表示GPU在节点内部的性能扩充。例如:增加Compute die或HBM的数量、性能;增加服务器等节点内的GPU数量,通过PCB、铜线等进行小范围互联;有时会增加一层交换芯片,例如PCle Switch、NVSwitch都是算力Scale Up的一部分。(传统的AI4卡、8卡、16卡服务器都是典型的Scale Up形式。)

Scale-up系统往往对基于算力优化的网络协议与标准有更高技术要求。代表性的Scale-up网络包括英伟达多年迭代的NVLink、基于AMD早期Infinity Fabric协议的UALink、博通发布的Scale UpEthernet(SUE)等,拥有更高的带宽和信令速率,从底层协议到系统硬件一般均独立与传统通信网络。例如英伟达的Blackwell芯片,其NVLink带宽达到1.8TB/s,由18个Port构成,每个Port 100GB/s、四对差分线构成、包含两组224Gbps的Serdes。

Scale Up场景:张量并行、专家并行等,高频交互、内存读写是重点,通常放在超高带宽、超低时延的网络中进行处理。Scale Up本质上是支持内存语义的网络。例如NVLink,在节点范围内实现内存语义级通信和总线域网络内部的内存共享,本质上是一个显存的Load-Store网络,性能和延迟均优于传统网络协议。一般Scale Up网络是GPU芯片直出互连,不采用传统网络的传输层和网络层,采用信用机制流量控制、链路层重传等机制保障可靠性。

上代Scale-up规模为8卡,英伟达Clos结构领先。8卡服务器时代Scale-up主要为两种拓扑。1)网状拓扑:GPU之间以“手拉手”形式实现全互联,无交换芯片导致通信压力集中于GPU上,且GPU一对一通信效率下滑。2)Clos拓扑:英伟达将引入交换芯片引入Scale-up,使通信压力集中于NVSwitch,GPU间形成无阻塞的全互联;通信带宽弹性较大,能更好处理通信峰值,使集群性能提升。

本文来自知之小站

报告已上传知识星球,微信扫码加入立享4万+深度报告下载及1年更新。3天内不满意退出星球款项原路退回,欢迎试用。到期续费仅需5折

(如无法加入或其他事宜可联系zzxz_88@163.com)